Il trasporto del segnale

Le interfacce di collegamento.

di Andrea Mordenti

Il video nasce per essere trasmesso. Sembrerà banale ma la sua funzione principale è quella di trasferire immagini e suoni da un luogo all’altro: che sia dall’altra parte del globo o dall’altro lato della stanza, il video corre su un cavo o su un’onda per raggiungere i dispositivi di visione e lo sguardo dello spettatore.

I protocolli per il trasporto del segnale video sono nati e si sono evoluti come parte integrante degli standard che hanno segnato lo sviluppo dei sistemi di ripresa e di riproduzione. I codici e le tecnologie in uso oggi provengono principalmente dall’industria televisiva che, ben prima che l’home-video diventasse un fenomeno di massa, ha dovuto affrontare la questione di come permettere ai suoi utenti di ricevere immagini e audio sincronizzati di qualità accettabile e con costi affrontabili. All’epoca della nascita della TV a colori l’infrastruttura esistente permetteva la trasmissione di un solo segnale video, il bianco e nero, il quale da solo occupava già tutta la banda a disposizione per ogni canale. Le telecamere a colori, come noto, catturano la luce utilizzando tre sensori differenti, uno per ogni colore primario, definiti come rosso, verde e blu (RGB). L’informazione luminosa viene quindi trasformata in tre segnali elettrici distinti che devono essere inviati a destinazione per ricomporre l’immagine di partenza. Si pose quindi il problema, dalla soluzione apparentemente impossibile, di triplicare il segnale da trasmettere a parità di banda a disposizione. Una o più sottoportanti potevano essere utilizzate per aggiungere dati alla trasmissione ma era comunque necessario ridurre la quantità di informazioni: il segnale RGB generato dalla telecamera non poteva essere trasmesso tal quale. Inoltre, come tutti i progressi tecnologici, anche la TV a colori aveva bisogno di un certo periodo di tempo per essere assimilata da tutti gli utenti e da tutti gli studi di produzione. Era necessario che entrambe le tecnologie potessero convivere per molti anni e fossero retro-compatibili.

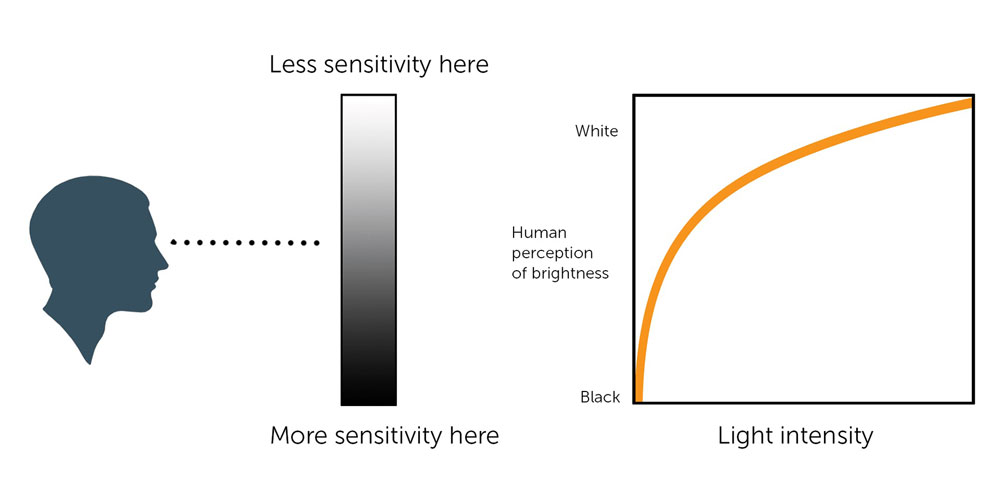

La percezione dell’occhio umano in funzione della luminosità non è lineare. L’occhio è sensibile a piccole variazioni di luce alle basse intensità, mentre con l’aumento della luminosità la sensibilità diminuisce secondo una curva che si approssima ad una funzione potenza con esponente 0,42. La percezione del 50% di luminosità, il cosiddetto grigio medio, si trova al 18% dell’intensità luminosa. La misurazione della luce da parte dei sensori CCD e CMOS avviene invece in maniera lineare. Uno degli elementi fondamentali nella transcodifica dei file video digitali, consiste nell’applicare quella che viene chiamata correzione di gamma, dove il valore γ rappresenta l’inverso dell’esponente della funzione potenza applicata. La Rec.709 stabilisce di applicare alla fonte una funzione potenza con esponente 0,5 mentre tipicamente un televisore HD secondo le specifiche BT.1886 ha γ=2,4. Combinando i due valori si ottiene un correzione γ complessiva di 1,2, necessaria ad una visione percettivamente lineare in condizioni di media luminosità.

Gli studi sulla visione umana dei secoli scorsi avevano già portato all’evidenza che le differenze di luminosità e i contrasti di grigi contribuiscono alla percezione di un’immagine da parte del nostro occhio in maniera preponderante rispetto alle gradazioni di colore e alle differenze cromatiche. In altri termini i toni di luce di un’immagine – ovvero la sua versione in bianco e nero – ci forniscono già gran parte delle informazioni necessarie a leggerla, a comprenderla e a contestualizzarla. Se da una parte la visione di un video a colori genera un’esperienza più affine alle nostre aspettative di spettatore rispetto alla visione di un video in bianco e nero, il dato del colore contribuisce all’esperienza in misura minore rispetto al dato della luminosità.

Questo aspetto fisiologico diede il supporto scientifico che permise di superare le difficoltà tecniche. Si stabilì di lasciare inalterato il segnale in bianco e nero e di inviare le informazioni di colore separatamente modulando le sottoportanti: un segnale distinto, quindi, che sarebbe stato semplicemente scartato dalle TV in bianco e nero. Dai tre segnali RGB viene estratta la sola componente di luminosità, che è definita come 30% del segnale del rosso, 59% del segnale del verde e 11% del segnale del blu. In pratica il 30% di qualsiasi differenza di potenziale che io misuri sull’uscita del chip del rosso mi dà il valore della luminosità che il chip del rosso rileva. Lo stesso per il verde e per il blu. I bianchi, i neri e i grigi si ottengono quindi sommando il 30% del segnale del rosso al 59% del segnale del verde e all’11% del segnale del blu. Questa componente del segnale complessivo viene detta Luminanza o Y e costituisce, insieme alla traccia dei sincronismi, il video in bianco e nero che viene trasmesso sulla banda principale ed è la porzione di segnale che viene letta dagli apparecchi TV in bianco e nero.

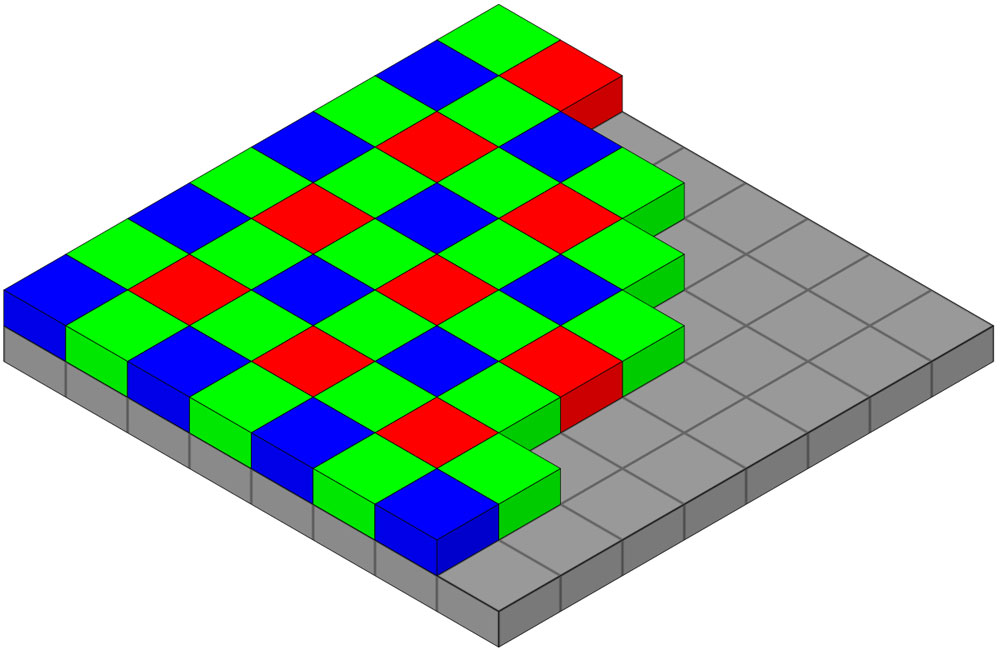

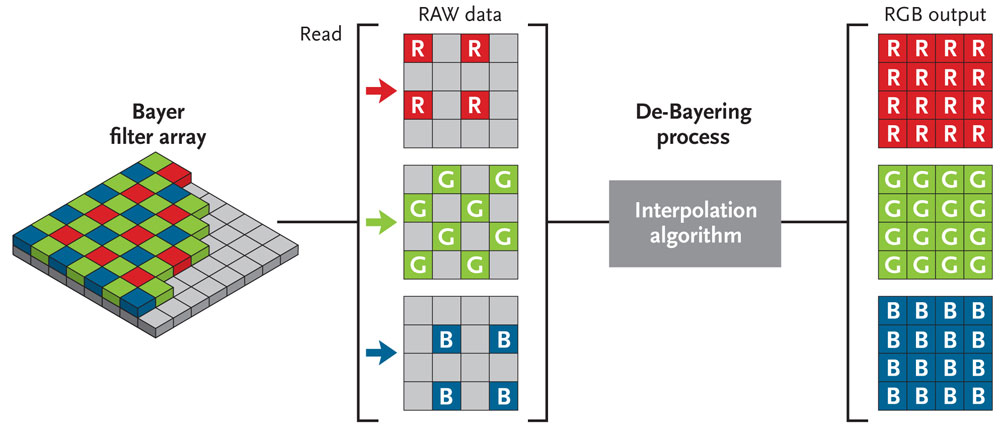

I semiconduttori CCD e CMOS non sono in grado di rilevare la lunghezza d’onda e quindi il colore, ma solo l’intensità della luce che li colpisce. Per ottenere l’informazione cromatica viene utilizzato il filtro di Bayer (o Bayer pattern) che prende il nome da Bryce Bayer, ricercatore della Kodak che fu il primo a proporlo. Davanti a ogni sensore viene posizionata una matrice di filtri colorati disposti a formare un mosaico in cui per ogni due filtri verdi ce ne sono uno rosso e uno blu. In questo modo ogni fotosito registra solo l’intensità di un colore primario e non di tutto lo spettro.

La componente rimanente del segnale si chiama Crominanza o C ed è rappresentata dalla differenza tra i segnali RGB di partenza e la componente Y già inviata, quindi R-Y (Rosso meno Luminanza), G-Y e B-Y. Di questi tre valori, conoscendone già la somma in Y, posso trasmetterne solo due e ricavare il terzo per differenza. La transcodifica del colore, attraverso questi semplici calcoli, avviene in automatico all’interno delle macchine da presa e dei monitor, il flusso di segnale così generato viene denominato YPbPr, che nel digitale è diventato YCbCr, sigle che stanno entrambe a significare che i valori RGB di partenza non vengono inviati tal quali ma transcodificati per il trasporto (su cavo o su onda) in tre segnali differenti che sono Y, Blu-Y e Rosso-Y. La trasmissione delle due sole componenti di differenza cromatica, in aggiunta alla luminanza, comporta la riduzione del segnale di oltre un terzo rispetto ai valori RGB di partenza.

I valori dei due colori mancanti vengono successivamente calcolati a partire dai valori dei pixel adiacenti. Il processo è chiamato de-bayering o de-mosaicizzazione e può avvenire automaticamente nelle macchine da presa o successivamente attraverso i software di post-produzione.

Nel passaggio al digitale e all’HD, per limitare ulteriormente la banda necessaria alla trasmissione del colore (dato l’incremento della risoluzione) e basandosi ancora una volta su studi percettivi, si stabilì che l’informazione cromatica potesse essere ulteriormente ridotta attraverso il sottocampionamento. In pratica i dati del colore vengono rilevati ad una frequenza che è la metà della frequenza di campionamento della luminanza. Codici numerici come 4:2:2 riferiti a un contributo video o a un segnale di trasporto video stanno a indicare che, posto uguale a 4 il campionamento di Y, il campionamento di Cb e Cr è 2, quindi la metà. Un segnale 4:4:4 non è sottocampionato e porta tutte le informazioni necessarie per ricostituire i valori RGB di partenza. Un segnale 4:0:0 non ha informazioni di colore ed è quindi un video in bianco e nero. Altri schemi come 4:2:0 e 4:1:1 rappresentano metodi differenti di sottocampionamento, mentre l’aggiunta di una quarta cifra (4:4:4:x) sta ad indicare la presenza di un eventuale canale Alpha, ovvero un’informazione di trasparenza o chiave. La separazione tra Luminanza e Crominanza e l’utilizzo della differenza cromatica hanno permesso al video analogico di essere trasportato e immagazzinato in maniera più efficiente, utilizzando minore quantità di dati (di nastro) rispetto all’utilizzo dell’RGB nativo e, insieme al sotto-campionamento del colore, vengono ancora utilizzati nei sistemi digitali attuali.

SDI

Un flusso video in ambito professionale e broadcast utilizza generalmente l’interfaccia SDI (Serial Digital Interface). Nata per la TV digitale in definizione standard (PAL e NTSC) sfrutta cavi coassiali con impedenza nominale a 75 ohm e connettori BNC, gli stessi utilizzati da sempre nei sistemi televisivi. L’SDI non richiede codec, il segnale è digitale, a componenti e senza compressione. Nelle definizioni Standard (270 Mbps) e HD (1,5 Gbps) lo schema del segnale è tipicamente YCbCr 4:2:2. La trasmissione è seriale, ad ogni pacchetto di dati segue il successivo secondo un flusso che si può rappresentare nel seguente modo: Cb Y Cr Y Cb Y Cr Y ecc. ad indicare che la luminanza Y viene trasmessa a frequenza doppia rispetto ai valori di differenza cromatica. Lo sviluppo dell’interfaccia ha seguito la rapida evoluzione del settore con l’incremento progressivo delle risoluzioni e delle frequenze di campionamento. Il 3G-SDI è il più utilizzato per i filmati Full-HD e fino a 2K-CGI@60p con codifica colore 4:4:4; l’ultima versione è l’attuale 12G-SDI che con i suoi 12 Gbps di banda garantisce una risoluzione di 4K-CGI@60p con codifica colore 4:4:4 oppure 4:4:4:4 – con canale alpha, quindi – ma a 30p.

Anche se non è sempre utilizzato per questo scopo, nel protocollo SDI è prevista una banda dedicata per 16 canali audio ed è idoneo quindi – e difatto molto spesso utilizzato – per distribuire un timecode SMPTE. La lunghezza massima di un cavo SDI è attorno ai 90 metri, adatta ad un ambito di lavoro professionale, ma diminuisce drasticamente con le ultime versioni ad alta frequenza che richiedono, naturalmente, anche cavi più prestazionali. Il fatto che ogni standard sia retro-compatibile (rispettando le risoluzioni massime) e il connettore a baionetta sia molto solido e allo stesso tempo facilmente sostituibile con una pinza crimpatrice, hanno permesso all’SDI di attraversare le epoche storiche e probabilmente sarà ancora lo standard del prossimo futuro per tutto quel che riguarda l’ambito tipicamente video, ma con un limite: non è possibile utilizzare un cavo SDI per risoluzioni e formati non standardizzati dall’industria televisiva, non funziona! Il protocollo SDI non è adatto alla computer grafica.

A un certo punto della storia i mondi del video e dell’informatica si sono incontrati, con grande beneficio per entrambi i settori. L’incontro era assolutamente prevedibile perché fin dall’inizio entrambi i sistemi condividevano un mezzo, cioè il monitor a cristalli liquidi CRT, pur se utilizzato con finalità diverse e secondo codici e convenzioni proprie di ognuna delle due industrie. Fin dai primi anni ‘90, in ambito corporate, i videoproiettori LCD stavano sostituendo i proiettori per diapositive, a loro volta soppiantate dalle presentazioni in Power Point. Verso la fine del decennio e nei primi anni 2000 l’incremento della luminosità ne aveva ampliato le possibilità di utilizzo; la possibilità di avere macchine di dimensioni contenute, a costi affrontabili, relativamente silenziose e con una luminosità ragionevole (10.000 ANSI-lumen) aprì la strada alla realizzazione di schermi sempre più ampi e all’utilizzo della videoproiezione per nuove finalità scenografiche e spettacolari. Nello stesso tempo, rapidamente, con la digitalizzazione dei contenuti, scomparvero tutti i lettori video – nella babele di standard e supporti che via via si erano succeduti – e la sorgente delle immagini da proiettare diventò il personal computer. In questo cambiamento radicale e piuttosto rapido chi avesse voluto anche solo semplicemente proiettare un filmato avrebbe dovuto usare un cavo VGA.

Il media server Disguise è dotato di vari slot in cui possono essere inserite delle schede di input e di output con connessioni e standard diversi, creando configurazioni complesse. In questo caso monta una semplice scheda con due output HDMI. Disguise è stato il primo media server a installare sui suoi hardware connessioni audio professionali sia input che output con connettore XLR stereo.

VGA

La sigla VGA (Video Graphic Array), oltre a rappresentare una famiglia di schede grafiche e una specifica risoluzione in pixel di un’immagine o di un video digitale (640 × 480 pixel), indica anche un particolare tipo di cavo e un connettore a 15 pin (DE-15 o D-sub). Il VGA, curiosamente, è un protocollo analogico, di fatto da un cavo VGA esploso è possibile ottenere i singoli segnali RGBHV: un cavo video component a tutti gli effetti, con i sincronismi orizzontali e verticali separati. Il cavo VGA era limitato alle basse risoluzioni dell’epoca – solo con l’ultima versione Super-VGA si arrivò al 1080p – ma del resto gli schermi LED non esistevano e monitor CRT e videoproiettori LCD avevano generalmente risoluzioni non superiori a 1024 × 768. Il VGA è comunque un cavo da computer grafica, non specifico per il video, non prevede il segnale audio ed ha lunghezza estremamente limitata: massimo 20 metri.

DVI, HDMI, DisplayPort

Gradualmente, dal 1999, sia in ambito professionale che home-theater, è stata introdotta l’interfaccia DVI (Digital Video Interface), un protocollo di trasmissione finalmente digitale e molto più solido del VGA, anch’esso senza audio e ancora più limitato in lunghezza: massimo 10 metri. DVI è stato per molto tempo lo standard in uso sia nella versione Single Link (3,96 Gbit/s, risoluzione massima 1920×1200@60fps), sia nella versione Dual Link (7,92 Gbit/s, 2560×1600@60fps).

La necessità di ridurre le dimensioni dei connettori e di integrare l’audio nel flusso ha portato infine alla nascita di HDMI e DisplayPort, le due interfacce che oggi si contendono il primato nel trasporto digitale del video in alta definizione. Entrambe utilizzano la compressione lossless VESA DSC 1.2. Il Display Port nasce in ambito professionale e ha il pregio di avere solitamente un pulsante sul connettore per impedirne il distacco accidentale. È presente in molte schede grafiche di fascia alta, anche nella versione mini-DP. L’ultima revisione 2.1 dichiara di poter trasportare fino a 16K a 120 Hz ma non è ancora utilizzata, mentre ampiamente diffuse sono le versioni 1.2 (fino a 4K@60fps) e 1.4 (fino a 8K@60fps). Queste specifiche sono limitate a cavi non più lunghi di 2 metri: oltre questa distanza e fino a un massimo di 15 metri viene garantito solamente il 1080p.

HDMI – High Definition Multimedia Interface, in italiano acca-di-emme-ai! – è uno standard di provenienza consumer. Presente nei decoder casalinghi della Digital TV e nella maggior parte dei PC domestici ha guadagnato negli anni la fiducia degli operatori professionali grazie alla sua affidabilità, facilità di reperimento e costi particolarmente contenuti. Nasce come versione ridotta del DVI con cui, fino alla versione 1.4, era retro-compatibile. La versione 2.0, la più diffusa, ha meno banda del Display Port (18 Gbps contro 21,6) ma sufficiente per la gran parte degli usi dato che supporta il 4K a 60fps e fino a 32 canali audio. L’ultima versione 2.1 raggiunge il 10K (ovvero un 8K esteso in formato 2,35:1) a 120fps con un profilo colore 4:2:0.

Come vediamo, i segnali audiovisivi generati dai computer, a differenza di quelli generati da una telecamera, non sono stati progettati per percorrere lunghe distanze e, salvo i casi in cui il player e lo schermo siano molto vicini, vi è la necessità di convertirli ulteriormente per il trasporto utilizzando generalmente adattatori attivi in fibra ottica o ethernet. Svariati modelli di extender consentono questa operazione ma è evidente che l’aggiunta al sistema di trasmettitori, ricevitori e cavi di altra natura ne aumenta notevolmente la complessità.

Il nuovo Watchpax 64 della svedese Dataton, oltre alle 4 uscite DisplayPort, implementa su 8 connessioni mini-BNC bidirezionali, configurabili indipendentemente come input o come output, 8 porte 3G-SDI oppure 2x12G-SDI o 1x12G-SDI e 4x3G-SDI.

HDBaseT

Nel tentativo di mettere alcuni punti fermi nella galassia dei convertitori di segnale per il trasporto sulle lunghe distanze, alcune tra le più importanti aziende del settore – tra cui LG, Samsung, Sony ed altre – hanno formato nel 2010 la HDBaseT Alliance, promuovendo un nuovo standard multimediale che, nelle intenzioni, vorrebbe sostituire l’HDMI. Le specifiche di HDBaseT prevedono un flusso che comprende un segnale video fino a 4K non compresso, audio digitale, Ethernet 100BaseT, USB 2,0 e potenza elettrica fino a 100 W in unico cavo Cat5/6 con lunghezza fino a 100 metri. Molte di queste funzioni non vengono ancora utilizzate a pieno e la proposta di standard è ancora giovane, ma i produttori di videoproiettori in gran parte hanno già da tempo introdotto questa connessione sulle loro schede di input. Il segnale viene convertito da HDMI (o DisplayPort) a HDBaseT a monte, nei pressi della scheda grafica, utilizzando per ogni singolo segnale piccoli trasmettitori che generalmente fungono anche da EDID-emulator, oppure specifiche matrici per installazioni più complesse. Il trasporto avviene su cavo Cat6 e non è necessario alcun dispositivo di ricezione poiché già integrato nel proiettore.

NDI

Anche se nasce per lo streaming è, di fatto, oggi, uno dei vari metodi che si possono utilizzare per trasportare un contenuto multimediale da un luogo ad un altro – anche nella stessa stanza, quindi – con una latenza molto bassa e ad alta definizione. Sviluppato dalla NewTek, NDI (Network Device Interface) è un protocollo IP-based che, nella versione 5, sfrutta il Reliable-UDP (RUDP) per trasmettere audio e video sul network combinando i vantaggi della bassa latenza dell’UDP con l’affidabilità del TCP. In un ecosistema NDI possono convivere differenti apparati di ricezione e trasmissione per creare le configurazione più complesse in tutti i vari settori in cui il video prevale come forma di interscambio di informazioni, dal gaming al medicale, dagli eventi corporate ai workflow sincronizzati per produzioni e post-produzioni in remoto. NDI non è un codec – anche se utilizza un codec proprietario per spacchettare i fotogrammi e inviarli a destinazione – quindi funziona anche con gli altri codec come h264, h265, ecc. La latenza tecnica dichiarata è di 16 linee di scansione video, in pratica meno di un field (mezzo frame).

E l’audio?

Alla fine ci troveremo tutti con in mano un cavo di rete… L’audio segue le sue logiche e le sue strade e generalmente è trattato separatamente rispetto al segnale video. Per esempio nella trasmissione televisiva analogica se il video veniva trasmesso modulando la portante in ampiezza (AM), l’audio veniva trasmesso modulando la portante in frequenza (FM) e i due segnali ri-sincronizzati alla ricezione. Nel caso della messa in onda di un filmato, se, come abbiamo visto, il lettore è generalmente un personal-computer, fino a poco tempo fa c’erano solo due strade percorribili per trasmettere l’audio: l’uscita analogica del PC – mini-jack stereo nel peggiore ma ahimè più diffuso dei casi – o la scheda audio USB, con tutte le complicanze relative ai driver proprietari. Il rapido sviluppo del sistema DANTE (Digital Audio Network Through Ethernet) sta portando molti produttori di media server e image processor ad implementare questo protocollo sui loro hardware, una piccola rivoluzione che, una volta assimilata, semplificherà notevolmente per tutti il flusso di lavoro.

Fonti:

- Marcus Weise, Diana Weynand “How Video Works” Focal Press

- Piervincenzo Nardese “Tecniche di Video Digitale” Apogeo

- https://www.dptrek.it/direzione-della-fotografia/sdi-vs-hdmi/

- https://skyandtelescope.org/astronomy-resources/astrophotography-tips/

redeeming-color-planetary-cameras/ - https://www.pixelsham.com/2018/04/01/gamma-correction/

- NewTek NDI https://docs.ndi.video/all/getting-started/white-paper

- Wikipedia