Dell’Auto-Tune e le sue colpe

Lo strano cammino che ha trasformato un semplice plug-in per sound engineer nel marchio di fabbrica della musica dei primi anni Duemila.

di Giovanni Seltralia

Corre l’ottobre del 1998 quando Cher rilascia il singolo Believe e inizia a scalare le classifiche di tutto il mondo. Il verso “I can’t break through” suona immediatamente strano: una voce robotica, post-umana, assimilabile a certi effetti vocoder della disco music, compare tra le strofe della canzone e si ripresenta con una certa insistenza. Il trucco dei produttori della canzone, Mark Taylor e Brian Rawling, non viene subito svelato: le tecnologie di pitch-correction sono già sul mercato da qualche tempo ma, dopo un’introduzione in sordina, si presentano in questo brano per la prima volta al grande pubblico.

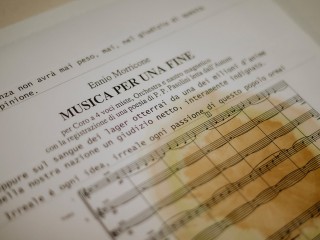

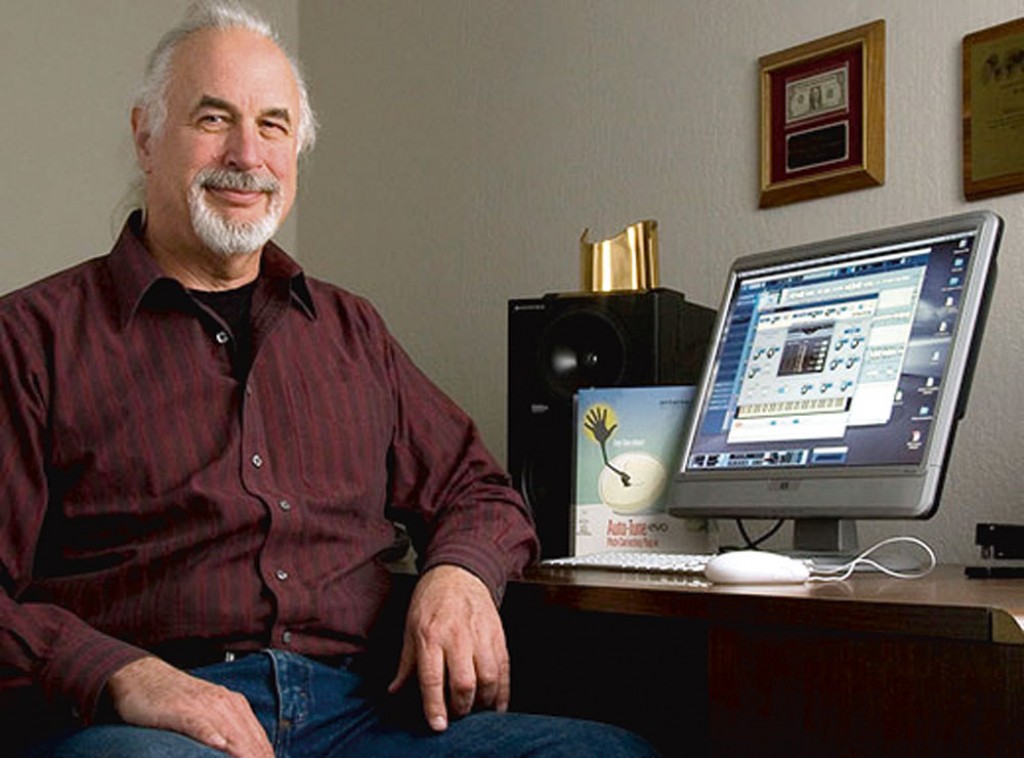

L’uomo ‘colpevole’ di questa storia è il matematico Andy Hildebrand, fondatore della Antares Audio Technologies: dopo un passato nella multinazionale Exxon a ideare algoritmi per individuare i pozzi di petrolio, il Dottore decide di seguire la sua passione per la musica, fondare un’azienda e, nel 1997, lanciare il celebre “correttore di intonazione” noto come Auto-Tune. L’obiettivo è semplice: “Quando le voci o gli strumenti sono stonati, si perdono le qualità emotive dell’esecuzione”, recita il brevetto della nuova tecnologia; bisogna dunque trovare il modo di facilitare l’intonazione.

Disponibile come hardware stand-alone, ma più comunemente usato come plug-in per workstation audio digitali, l’Auto-Tune viene applicato per anni nella correzione in studio dell’intonazione dei cantanti pop, come prefigurato nel brevetto. La tecnologia permette dunque di selezionare e modificare la tonalità chiave della performance, oltre a fornire il controllo su alcuni altri parametri come la velocità di “retune”, che regola la lentezza o la velocità con cui una nota identificata come off-key viene spinta verso il pitch corretto. La definizione inglese è spesso quella di “pitch quantization”, per affiancare il procedimento a quello parallelo di quantizzazione delle parti ritmiche già ampiamente utilizzato in tutti gli studi del mondo.

Più la velocità di messa in tono è alta, più l’effetto generato è simile al brano di Cher e a quel timbro robotico che oggi conosciamo fin troppo bene: l’umano diventa super-umano e la voce fisica si trasforma in un’entità generata matematicamente.

Nel corso degli anni Duemila, l’utilizzo “nascosto” del software – per intonare chi non è intonato – perde man mano di interesse e si limita a entrare nelle pratiche quotidiane di qualunque fonico; al contrario, si fa sempre più largo un utilizzo sperimentale per la creazione di timbri meno realistici possibile, in senso volutamente anti-naturalista. In particolare, il cambiamento avviene quando l’Auto-Tune da effetto correttivo limitato alla post-produzione diventa un processo in real-time: cantanti, e in particolare rapper, chiedono di sentire in cuffia la propria voce processata per imparare come gestirla e spingere ai limiti l’effetto artificiale; diversi fonici smettono addirittura di registrare la voce pulita in parallelo a quella processata, così che la performance originale tante volte nemmeno esiste. Contemporaneamente, l’effetto entra nel mondo del live e nei rack di molti monitor engineer.

Ora della fine del decennio, rapper americani come T-Pain, Future, Quavo, fanno della loro voce da cyborg un vero e proprio marchio di fabbrica; la musica “urban” arriva a influenzare pesantemente il pop, e l’Auto-Tune compare in diverse hit del decennio, come Umbrella di Rihanna o Firework di Katy Perry. In Italia arriva naturalmente sull’onda del rap e della trap e occupa le posizioni alte delle classifiche – singolare però il fatto che il primo esempio al mondo di rap trattato con il caratteristico effetto robotico venga proprio da un gruppo dance italiano, gli Eiffel 65, nel singolo Too Much of Heaven del 1999.

Tra i software, la concorrenza nasce già nei primi anni Duemila: Melodyne, dell’azienda Celemony, introduce alcune interessanti novità e un nuovo metodo di lavoro. Il software riconosce e registra graficamente le performance, dando la possibilità di vedere ogni nota singola e di correggerla o spostarla a piacimento con una vasta serie di effetti; in particolare, Melodyne introduce per la prima volta il riconoscimento e la possibilità di operare su materiale polifonico.

Ora, le critiche mosse all’uso massivo di questa tecnologia sono principalmente due.

La prima è facilmente comprensibile: utilizzare un correttore sull’intonazione significa inserire un ulteriore filtro tecnologico e falsare le reali capacità di un artista. Un po’ come la chirurgia plastica, l’Auto-Tune è una sorta di artificio che migliora le caratteristiche base di una performance; è però utile notare che il lavoro di taglia-e-cuci di un fonico nel ricostruire la take perfetta è già di per sé un artificio importante, anche senza considerare tutti quegli effetti che già nell’epoca pre-digitale rendevano anti-naturaliste le performance dei cantanti – Elvis veniva processato in uno slapback echo, i Beatles usavano il double tracking, e così via.

La seconda critica, più seria, è che il processo di pitch-shifting tende a spersonalizzare la voce e, in definitiva, a rendere tutti uguali i timbri dei cantanti. L’Auto-Tune rischia di svuotare la voce di alcuni suoi aspetti caratteristici e personali, come rumori e grattati in particolare nelle frequenze più basse, restituendo voci da “telefono” che è difficile distinguere tra loro. Si tratta di una critica di tipo tecnico, del tutto simile al dibattito sulla “loudness war”: la personalità di un cantante o di una performance si appiana a tutti gli altri prodotti del mercato, rendendo piatta l’offerta come i panini tutti uguali di un fast food.

Parole forti sono venute da Steve Albini, musicista e ingegnere audio di riferimento per il mondo del rock ‘alternative’: “Chiunque aggiunga l’Auto-Tune alla propria registrazione, deve sapere che sta condannando quella registrazione all’obsolescenza”. Dunque, l’Auto-Tune starebbe alla musica dei nostri tempi come le batterie e i riverberi iper-compressi – le “gated drums” – stavano agli anni Ottanta: si tratta di caratteristiche sonore, a metà strada tra creatività artistica e necessità tecniche, che hanno segnato il sound di ogni decennio. A voler essere puntigliosi, anche i suoni grezzi di Steve Albini per Nirvana e Pixies suonano pesantemente anni Novanta.

In definitiva, le tecnologie di pitch-shifting hanno avvicinato e quasi dissolto la differenza tra rapper e cantanti più o meno intonati, aprendo spazi tradizionalmente destinati al bel canto anche agli outsider. L’elemento positivo deriva ovviamente dal fatto che qualunque sperimentazione può portare a possibilità nuove, nel bene e nel male; in particolare a livello di sound design l’attenzione si è spostata sulla voce e sulla possibilità di scolpirla come si è fatto per molto tempo con il suono degli strumenti. Quando tutto in uno show – o addirittura nella società – è portato digitalmente all’estremo, quando le immagini sono iper-editate, quando gli schermi prendono il sopravvento sui palchi, allora è normale che anche la voce venga inclusa in questa tendenza. Forse il decennio appena iniziato vedrà un passo indietro e un ritorno alla “carnalità”, ma è ancora presto per dirlo.